Automatisation du Résumé du Journal Officiel par Modèles de Langage Légers

Approches : Prompt Engineering et Fine-Tuning

Joris Salmon

Nolwenn Chapellon

Année : 2024-2025 • Promotion Mars 2025

Contexte & Problématique

- Journal Officiel : volume immense, langage juridique complexe

- Défi d'accès à l'information pour les journalistes

- LLM : puissants, mais coûteux et peu adaptables

- SLM : économiques, agiles, et spécialisables

Comment générer des résumés rigoureux, synthétiques et exploitables du Journal Officiel, avec des modèles de langage légers ?

État de l'Art : Prompt Engineering

- Optimisation des instructions pour guider le LLM

- Objectif : réponses pertinentes sans modification du modèle

- Techniques : Zero-Shot et Few-Shot

- Approches avancées : Chain of Thought (CoT)

- Limite pour les SLM : Insuffisant sans adaptation profonde

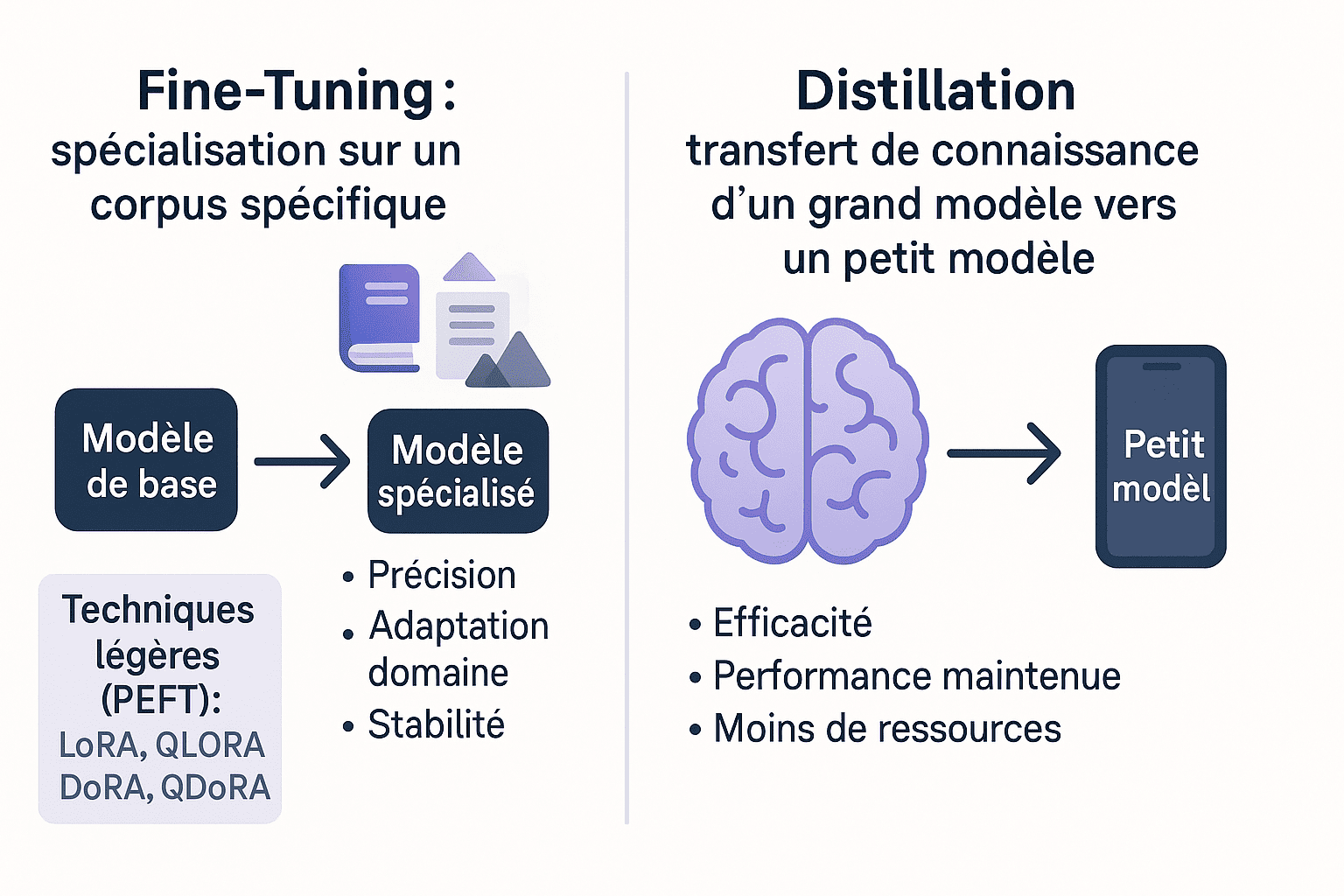

État de l'Art : Fine-Tuning & Distillation

- Fine-Tuning : spécialisation sur un corpus spécifique

- Apporte précision, stabilité, adaptation au domaine

- Techniques légères (PEFT) : LoRA, QLoRA, DoRA, QDoRA

- Distillation : transfert grand modèle → petit modèle

- Combinaison performance et efficacité

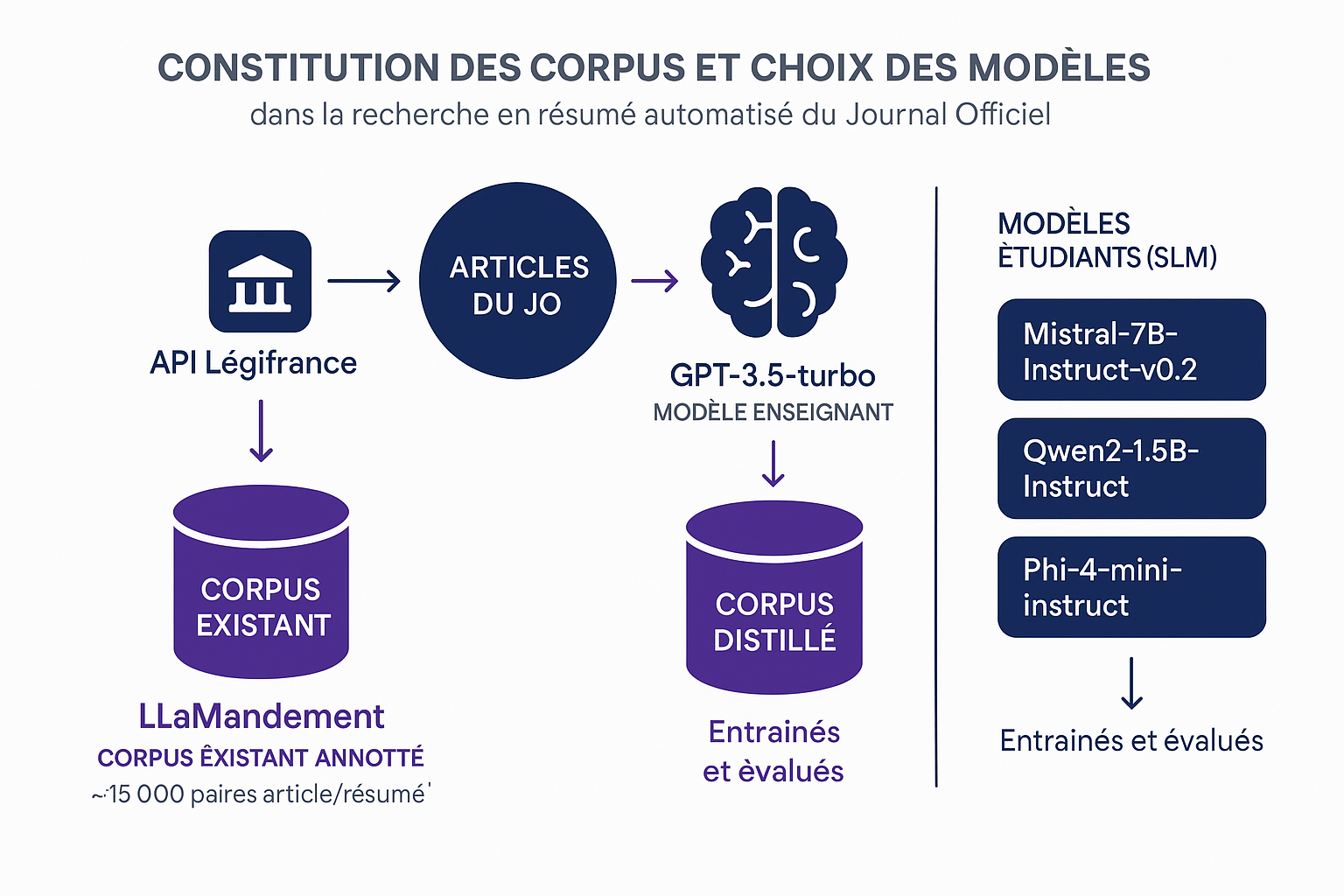

Méthodologie : Corpus & Modèles

Corpus : articles du Journal Officiel (API Légifrance)

- LLaMandement (~15 000 paires article/résumé)

- Corpus distillé : résumés générés par GPT-3.5-turbo

Modèles étudiants (SLM) :

- Mistral-7B-Instruct-v0.2

- Qwen2-1.5B-Instruct

- Phi-4-mini-instruct

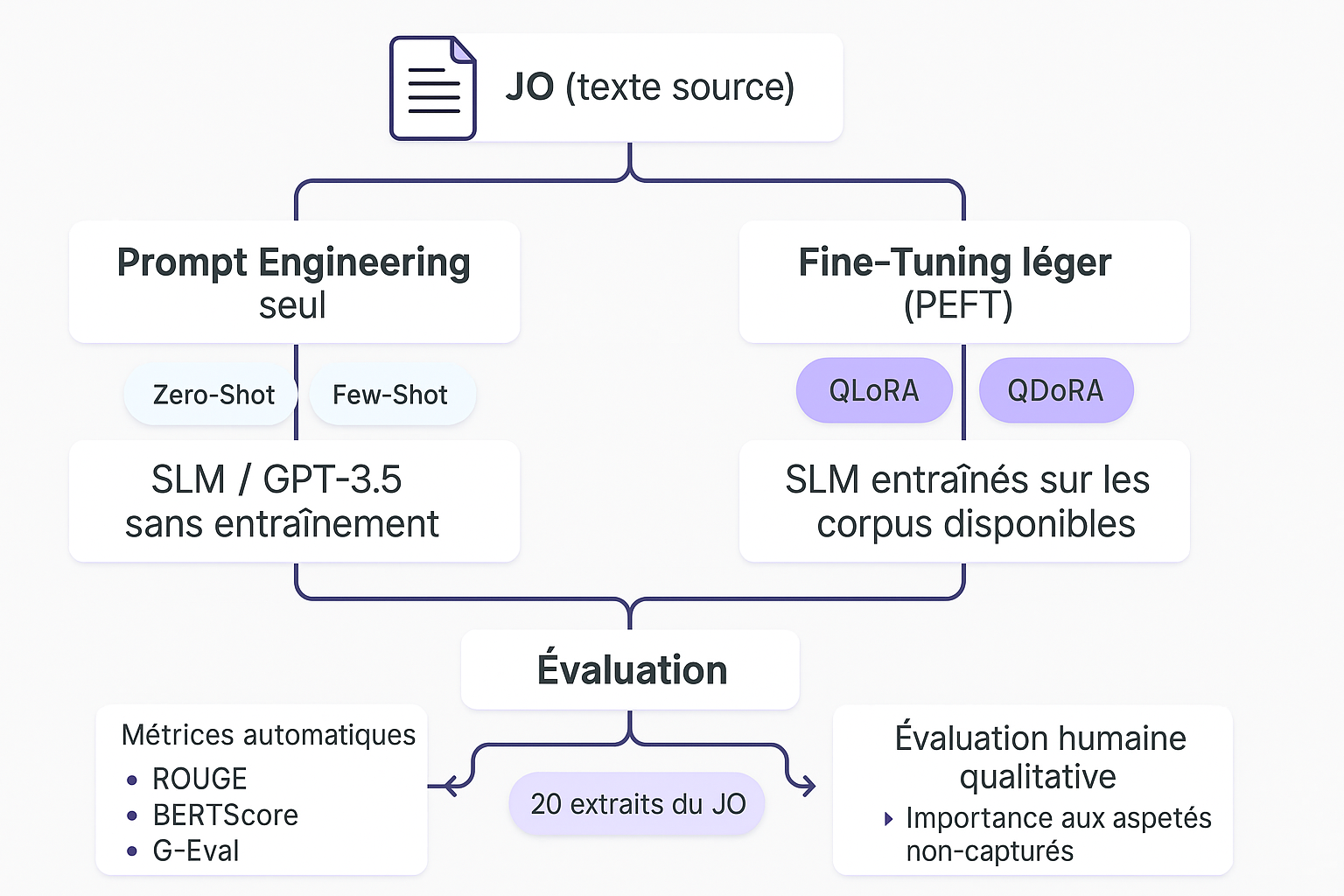

Méthodologie : Protocoles d'Expérimentation

Comparaison de deux approches :

- Prompt Engineering seul (Zero-Shot, Few-Shot)

- Fine-Tuning léger (PEFT) avec QLoRA et QDoRA

Évaluation sur 20 extraits du JO :

- Métriques automatiques : ROUGE, BERTScore, G-Eval

- Évaluation humaine qualitative

Hyperparamètres FT : Batch 1, Acc. 64, LR 1e-4, 4-bit quant.

Résultats : Phi-4-mini-instruct

| Métrique | Précis (FT vs Base) | Neutre (FT vs Base) | Créatif (FT vs Base) |

|---|---|---|---|

| ROUGE-1 F1 | +16.17% ↑ | -10.10% ↓ | -11.32% ↓ |

| BERTScore F1 | +5.00% ↑ | -3.23% ↓ | -1.78% ↓ |

| Note Qualitative | 3.5/10 → 7.5/10 | Dégradé | Dégradé |

Fine-Tuning essentiel pour Phi-4, notamment pour le style 'Précis'.

Dégradation notable des autres styles sans fine-tuning.

Résultats : Mistral-7B-Instruct-v0.2

| Métrique | Précis (FT vs Base) | Neutre (FT vs Base) | Créatif (FT vs Base) |

|---|---|---|---|

| ROUGE-1 F1 | +2.41% ↑ | -3.98% ↓ | +0.71% ↑ |

| BERTScore F1 | +0.27% ↑ | -1.72% ↓ | +0.16% ↑ |

| Note Qualitative | 8/10 → 7.5/10 | Dégradé | Amélioration vs GPT-4 |

Mistral : très performant de base pour le résumé juridique.

Fine-Tuning : valeur ajoutée limitée, améliore le style 'Créatif'.

Résultats : Qwen2-1.5B-Instruct

| Métrique | Précis (FT vs Base) | Neutre (FT vs Base) | Créatif (FT vs Base) |

|---|---|---|---|

| ROUGE-1 F1 | -11.38% ↓ | -19.91% ↓ | +13.56% ↑ |

| BERTScore F1 | -1.89% ↓ | -9.88% ↓ | +1.79% ↑ |

| Note Qualitative | Dégradé | Dégradé | 5/10 → 6/10 |

Pour Qwen, le Fine-Tuning est nécessaire.

Amélioration modeste, bénéficie principalement au style 'Créatif'.

Synthèse des Performances Clés (KPI)

| Modèle | Style | ROUGE-1 Gain (%) | BERTScore Gain (%) | Note Quali. (Base → FT) |

|---|---|---|---|---|

| Phi-4-mini | Précis | +16.17 | +5.00 | 3.5/10 → 7.5/10 |

| Mistral-7B | Précis | +2.41 | +0.27 | 8/10 → 7.5/10 |

| Qwen2-1.5B | Créatif | +13.56 | +1.79 | 5/10 → 6/10 |

Le graphique et le tableau montrent l'impact variable du Fine-Tuning.

Gains significatifs pour Phi-4 et Qwen sur leurs styles optimaux.

Mistral conserve son excellence intrinsèque.

Analyse Qualitative : Points Clés

Forces observées

- Résumés factuellement corrects

- Respect de la structure juridique

- Adaptation au style demandé

- Longueur appropriée (100-150 mots)

Faiblesses identifiées

- Parfois trop générique

- Manque de hiérarchisation des informations

- Répétitions dans certains cas

- Nuances juridiques parfois perdues

Observation majeure : Le Fine-Tuning améliore significativement la cohérence et la précision, mais l'efficacité varie selon l'architecture du modèle et le corpus d'entraînement.

Recommandations d'usage

- Mistral-7B : Prêt à l'emploi pour usage professionnel

- Phi-4-mini : Nécessite Fine-Tuning, excellent potentiel

- Qwen2-1.5B : Idéal pour prototypage rapide avec Fine-Tuning

Limites de l'Étude

- Ressources GPU limitées (contraintes sur modèles et itérations)

- Références générées par l'IA (GPT-4) : peuvent introduire des biais

- Volume de données d'entraînement modeste (limite la généralisation)

- Métriques automatiques : ne capturent pas toutes les nuances

- Nécessité de l'évaluation humaine complémentaire

- Test limité à un domaine législatif spécifique

- Variabilité des performances selon les types d'articles

Perspectives d'Amélioration

Court terme

- Augmenter le corpus d'entraînement

- Diversifier les types d'articles législatif

- Optimiser les hyperparamètres

- Tester d'autres techniques PEFT (AdaLoRA, etc.)

- Évaluation humaine plus extensive

Moyen terme

- Explorer d'autres architectures SLM

- Techniques de distillation avancées

- Adaptation à d'autres domaines

- Mise en production d'un outil user

Vision long terme : Développement d'un assistant IA spécialisé dans l'analyse et la synthèse de documents legislatifs, accessible aux professionnels du droit et du journalisme.

Conclusion & Enseignements

Oui, les SLM peuvent résumer le Journal Officiel de manière rigoureuse et utile !

Enseignements clés

- Fine-Tuning (PEFT) essentiel pour la spécialisation des SLM

- Efficacité varie selon le modèle et le style de génération

- Évaluation humaine indispensable pour valider la qualité

- Mistral-7B montre une excellence intrinsèque remarquable

- Phi-4 et Qwen bénéficient grandement du Fine-Tuning

Impact recherche

- Démonstration de la viabilité des SLM pour tâches spécialisées

- Méthodologie reproductible pour d'autres domaines

- Contribution à l'accessibilité de l'information législative

Questions ?

Merci de votre attention !

Joris Salmon

Étudiant Master 2 Data Analytics

Nolwenn Chapellon

Étudiante Master 2 Data Analytics